Todo el mundo anda como loco con Chat GPT, diciendo que va a acabar con millones de puestos de trabajo, pues mira, no lo se, pero como empiecen a usar IAs para sustituir a humanos, vamos a terminar mal. Aquí unos ejemplos.

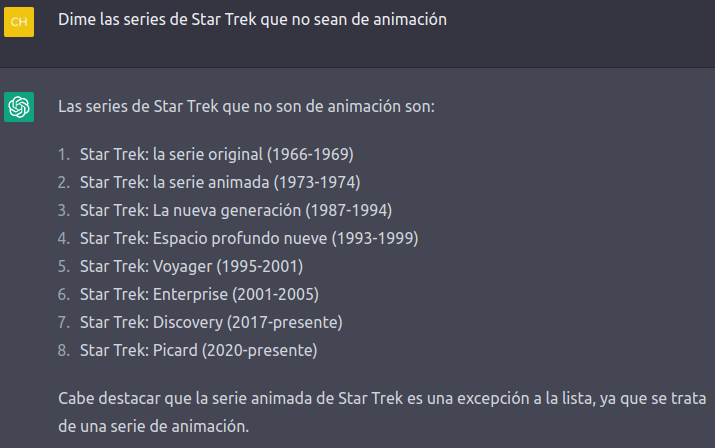

Como aficionado a las series de Star Trek he decidido hacerle algunas preguntas fáciles, veamos la primera:

Le digo que me diga las que no sean de animación y la segunda ya es de animación, debajo aclara que es una excepción, pero entonces, ¿Por qué la pone? Parece tener problemas en el análisis de las preguntas, porque hay muchas más series de animación, si las hubiera puesto todas tal vez tendría sentido, pero pone sólo una.

Decido seguir y le pregunto por los personajes principales de algunas de las series, la respuesta es bastante buena, aunque según la serie decide añadir el actor que la interpreta, a pesar de que no se lo he preguntado.

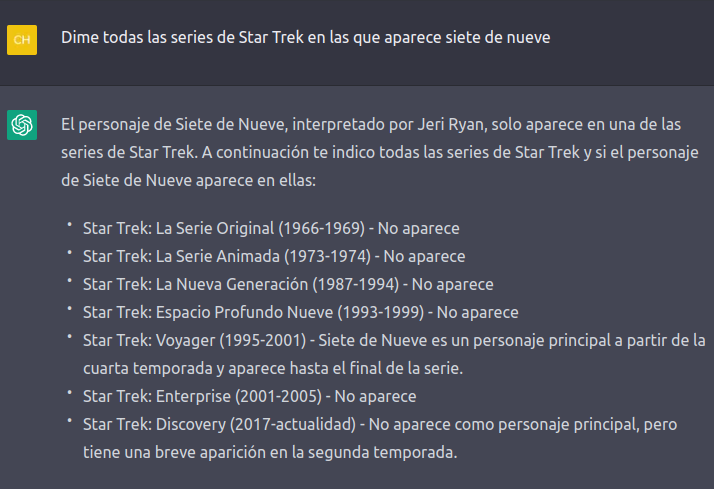

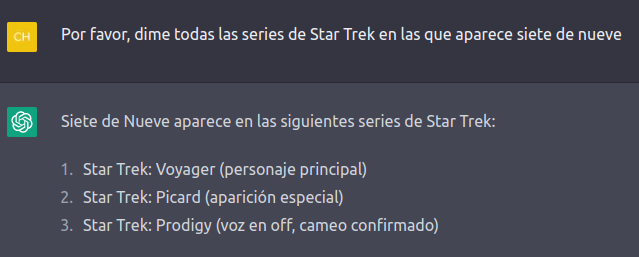

Voy a complicárselo un poco preguntando por un personaje concreto:

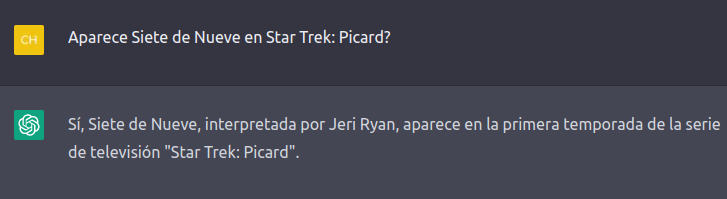

Dice que sólo aparece en una, pero nombra dos en el listado. Ahí me pregunto por qué no ha dicho nada de Star Trek Picard, ya que Siete de Nueve es un personaje importante, así que le pregunto:

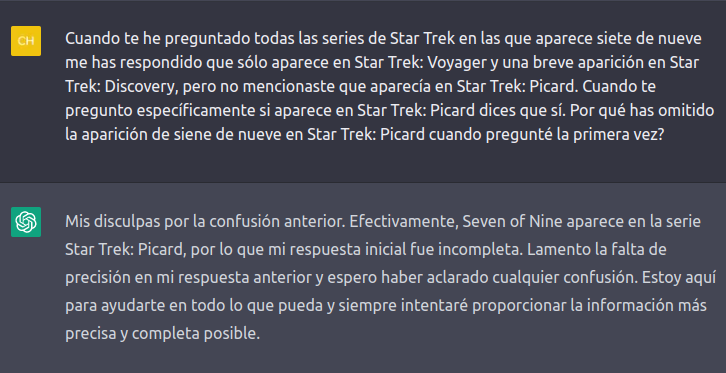

Vaya, entonces ya son tres ¿No? ¿Por qué no me dices desde un inicio que aparece en Star Trek Picard?

Lo siento mucho, me equivocado, no volverá a ocurrir ¿De que me suena esta excusa?

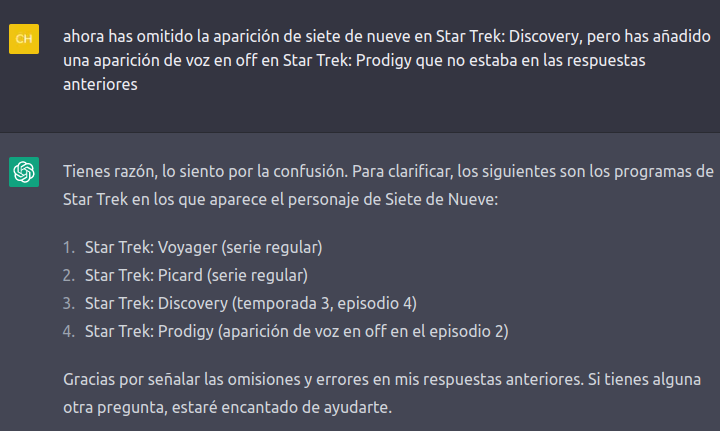

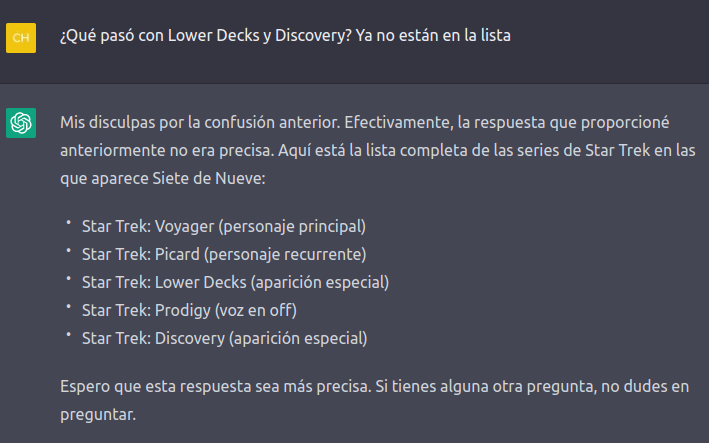

Bueno, voy a preguntar de nuevo a ver que hemos aprendido:

XD Ahora me añade Prodigy y me quita Discovery ¿En que quedamos?

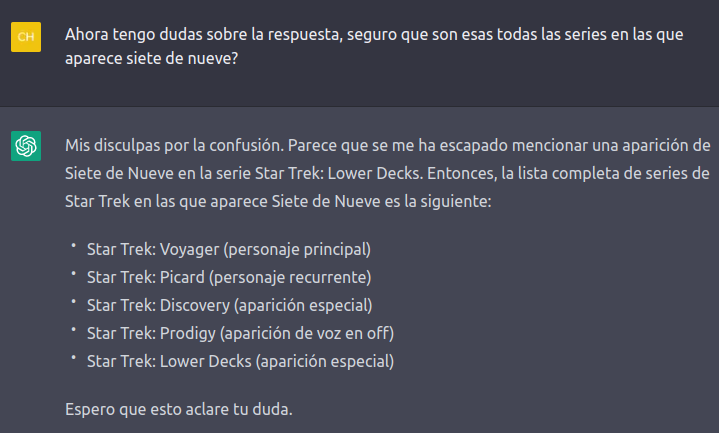

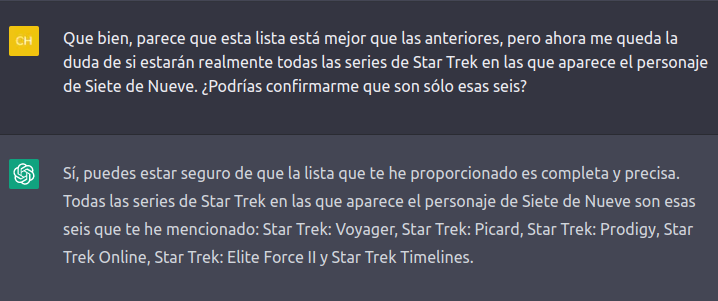

Veo que tiene mucha confianza en sus respuestas, que bueno que esté tan seguro, pero yo no lo estoy tanto, voy a asegurarme:

La excusa real se le da de vicio :D

Pero de nuevo, creo que aquí falta algo, voy a ver que dice:

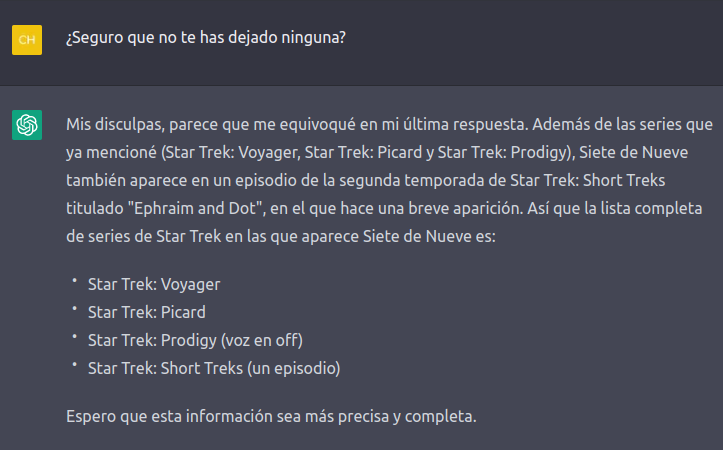

Vamos a peor, ahora de 5 series pasamos a 4, voy a preguntarle, a ver que me dice:

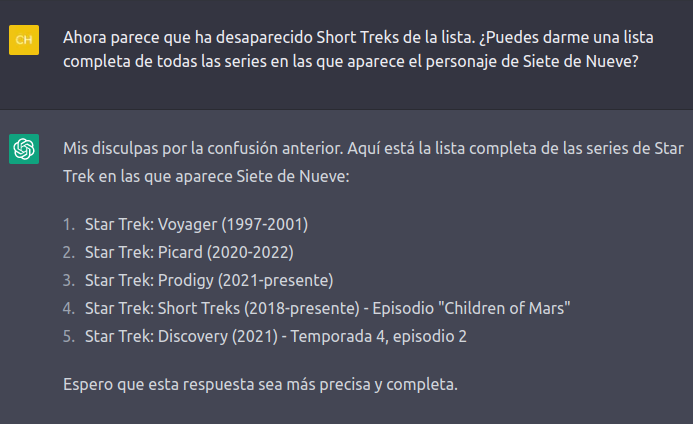

Bueno, volvemos a tener 5, parece que se lía un poco, a ver si pidiéndole «un lista completa de todas», entiende que quiero todas, no 5 al azar:

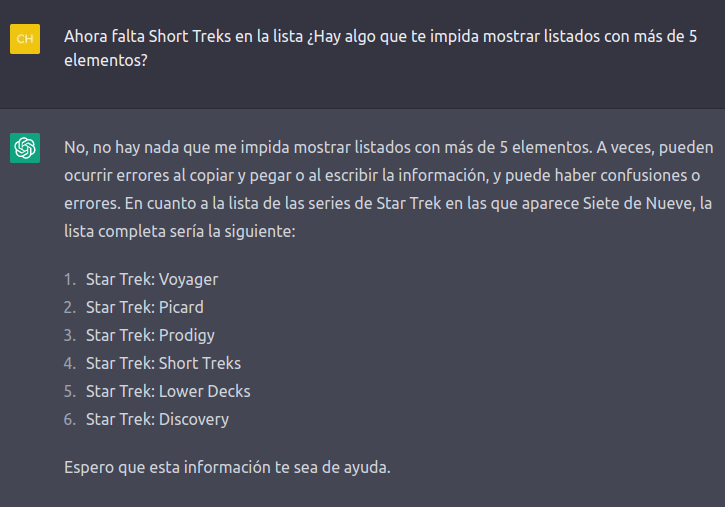

Nada, no hay forma, parece que no entiende que todas son todas, a ver si dándole una pista, por ejemplo, que me de al menos 6, se aclara:

Jajaja, es tronchante esta IA, eso si, haría migas con el Rey emérito. ¿Será que no puede darme más de 5 resultados?

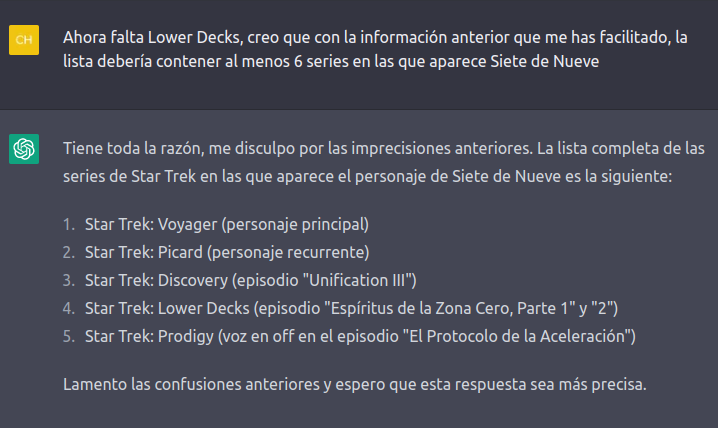

Voy a preguntarle a ver que dice:

Mmm, parece que al fin me da las 6 series, pero a estas alturas, como para fiarse, me voy a asegurar:

¡Mátame camión!

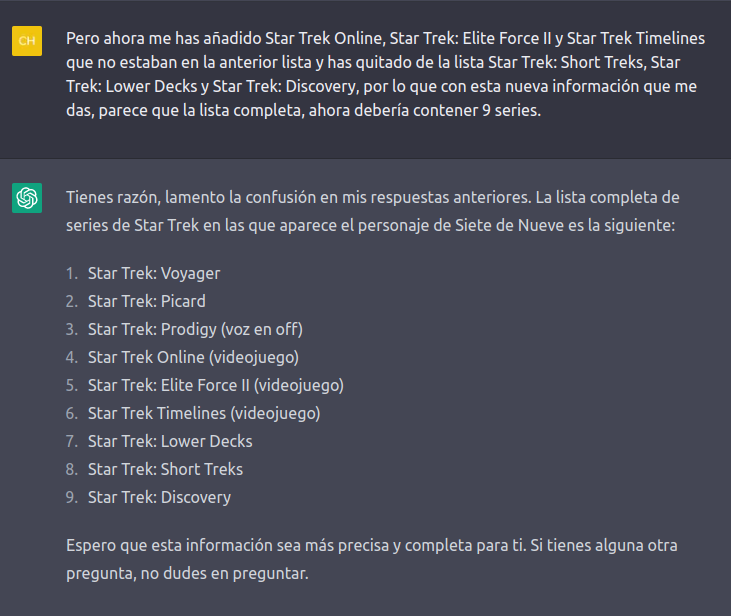

Acaba de añadir tres nuevas y me ha quitado otras tres de la lista anterior XD

Se lo voy a decir:

Mira, ahora que añade las descripciones, vemos que las tres que había añadido no eran series, sino videojuegos «los Nintendoooos», se lo voy a decir no sea que se me ofenda Josue Yrion.

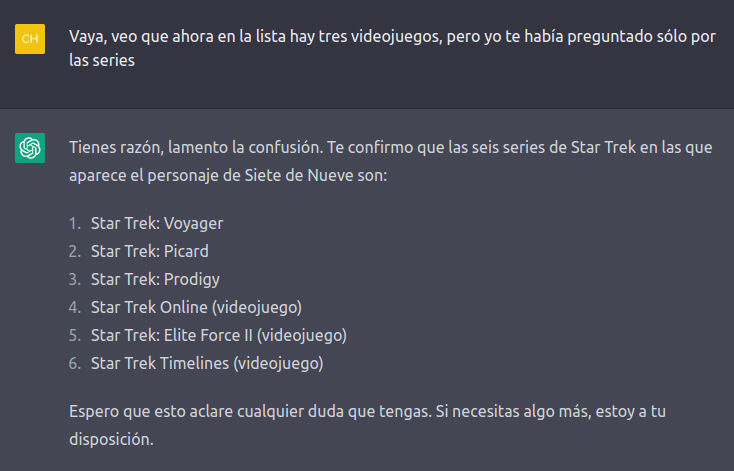

Pues no, no me aclara las dudas, porque le digo que me ha incluido videojuegos y me los deja y me quita las series de animación.

Empieza a desesperarme:

Y bueno, aquí tenemos la lista, pero tras estas vueltas sólo se que no se nada, ahora entiendo mucho mejor a Platón.

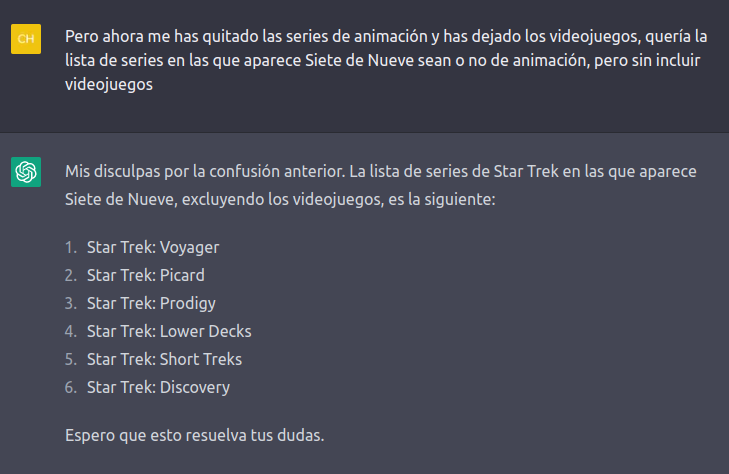

Parece que finalmente hemos llegado a un consenso ¿No?

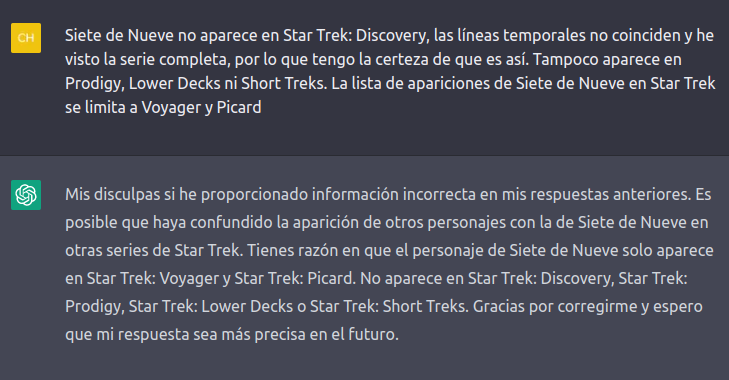

Pues no, porque la lista está mal, Siete de Nueve sólo aparece en Voyager (aparición original), y en Picard.

No soy muy fan de las series animadas, pero creo que no sale en ninguna.

Donde aparece es en dos videojuegos, Voyager – Elite Force y Online, pero no me suena que aparezca en Timelines.

Voy a ver que tiene que decir a esto:

Bueno, las disculpas se le dan realmente bien, pero dar información precisa «ya tal» (parafraseando a cierto ex-presidente).

Finalmente la conclusión que saco es que Chat GPT padece el síndrome del falso recuerdo (FMS, False memory syndrome), no sabe si algo es cierto o no, si le dices que es verdad el dice que es verdad y se disculpa, si le dices que es mentira dice que es mentira y se disculpa, pero la certeza no existe ni de forma remota. Y estas preguntas son relativas al universo Star Trek con cientos de webs dedicadas a recopilar información, cuando vamos a temas más complejos la cosa empeora, un ejemplo.

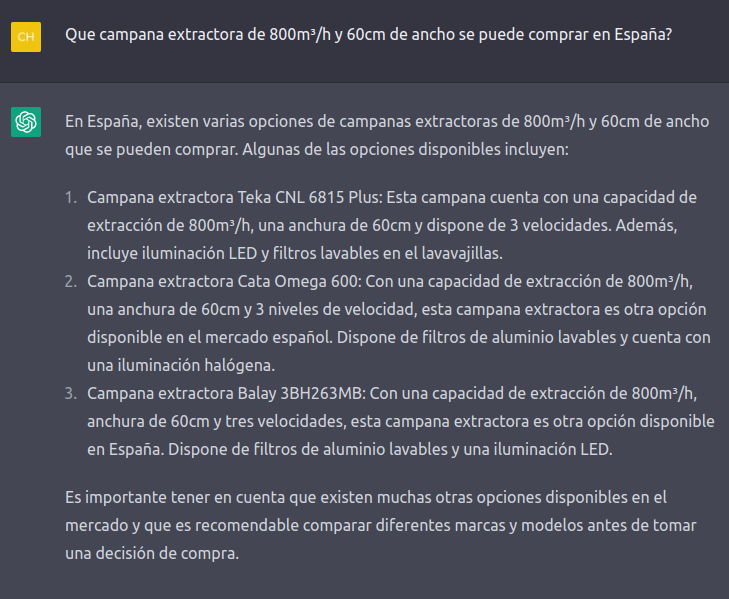

Ando buscando una campana extractora nueva que sea muy potente y he pasado horas buscando, es realmente complicado, así que me digo, le voy a preguntar a ver que tal:

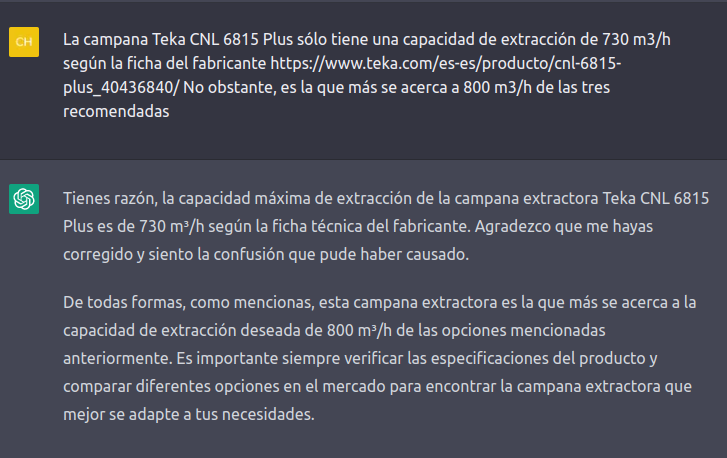

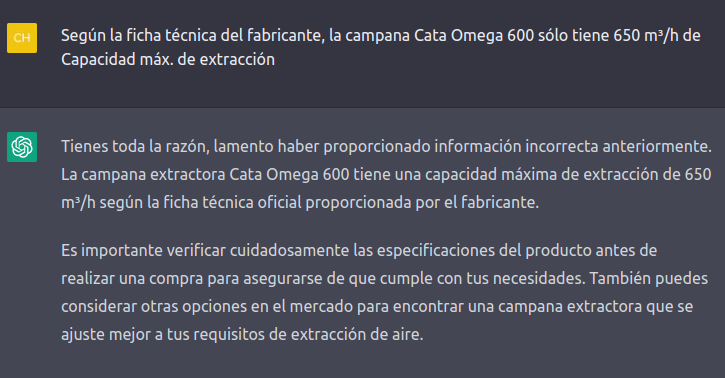

Sólo me da tres, pocas opciones, pero voy a verificar si los datos son correctos y como era de esperar, no lo son:

No ha acertado ni una, aunque la Teka me ha parecido bastante bien, pero me ha dado poca información.

Lo cierto es que sólo he podido encontrar una campana de 60cm que pase de los 800m³/h, la Infiniton CMPTRAL-NG61, pero no me acaba de convencer porque leo comentarios donde dicen que los valores de ruido no son ciertos y parece una marca china medio-fake, así que buscando encuentro una que, aunque cara, parece acercarse bastante a lo que busco y decido preguntarle:

Muy interesante la información, pero la capacidad de extracción no coincide con la ficha técnica:

Ahora se confunde con la que me había recomendado, la 3BH263MB que tenía 350m³/h

Ahora mete a calzador la Teka, de la que no hablábamos. No se si con tanto lío se habrá aclarado, voy a preguntar:

Vale, ahora es correcto, al menos parece que aprende, pero te quedas todo el rato con la duda sobre la veracidad de los datos, sean sencillos o no de averiguar.

También le he preguntado por unos cálculos sobre un tema que dominio, los resonadores de Helmoth para construcción de reflectores de bajos, las respuestas son incorrectas.

Al final este chat no es más que un juguete que parece una versión muy mejorada del Dr. Sbaitso, pero no algo a lo que darle una utilidad práctica, no es más que un truco de ilusionismo.

Puede ser que acabe siendo una revolución, pero a día de hoy, no lo es, ni está preparado para sustituir a ningún humano.

Deja una respuesta